加速迈入云原生时代,英特尔软硬一体的价值与角色

加速迈入云原生时代,英特尔软硬一体的价值与角色

进入 21 世纪后,虚拟机技术进入相对成熟阶段,由于虚拟机的“笨重”,开发者们开始追求一种更加轻便的虚拟化技术。

2010 年,由 NASA 和 Rackspace 联合开发的开源平台 OpenStack 诞生,帮助服务商和企业实现云基础架构服务。它将开源、开放的思想带到了云原生领域,并为云原生发展掀开了新篇章。

2020 年,OpenStack 基金会更名为开放基础设施基金会 OIF,OpenStack 从“云”拓展到了“开放基础设施”。

紧接着,OpenStack 从最初的虚拟化管理 Nova 和对象存储 Swift ,逐渐发展到包含虚拟化管理、SDN、SDS 服务编排和容器管理等功能覆盖全面的开源项目集合。

同时紧跟云原生技术演进潮流,与容器、Kubernetes、AI 相关的更多开源技术紧密合作。2021 年 11 月,OIF 基金会宣布了开放基础设施的新标准 LOKI —— Linux、OpenStack、Kubernetes 等组成的开放基础设施管理软件。

在今年 4 月,OIF 发布了 OpenStack Yoga 版本,并宣布,待下一个被称为终结者的 Zed 版本发布之后,OpenStack 将以稳定的状态成为企业 IT 的生产级工具。

这意味着云原生逐渐进入后 OpenStack 时代,2017 年起,各大云厂商都陆续开始包装和提供容器的商业化服务,提供基于 Kubernetes 的商业服务产品,容器技术逐渐走向成熟和标准化、商业化,成为虚拟化的新代表产品,围绕容器发展的云原生逐渐走向普适的阶段,已经应用容器的企业正在进行着云原生的新一轮技术演进。

一、后 OpenStack 时代的 Kubernetes :从“解决难用”到“用的好”

数字化转型的加速增加了企业对于云原生的需求,容器技术覆盖率提高,IDC 预测,容器软件市场在近几年呈爆发式增长,并且未来五年仍然会保持超过 40% 的复合增长率。

进而,企业对容器管理的需求会直线提升,容器管理成为企业数字化转型的主战场。据 Gartner 预测,到 2025 年,成熟经济体中 85% 的大型企业将更多地使用容器管理。

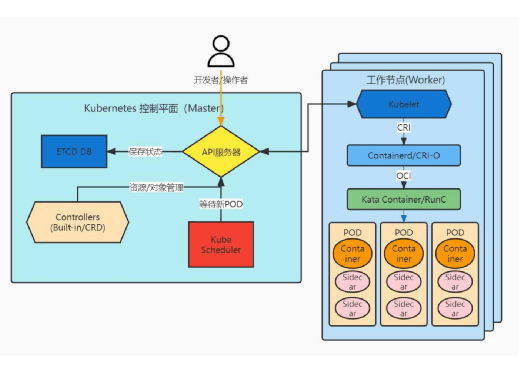

如今在大多企业的业务场景中,企业组织需要确保多个容器可同时协同工作,这方面的工作大部分都是又编排引擎完成。随着 Kubernetes 的兴起与演进,目前已经克服了容器编排过程中许多技术挑战。

或许因为 Kubernetes 想要解决的问题太多,所以导致其复杂度很高,于是不少企业也在应用其他容器管理解决方案。然而市场数据证明,Kubernetes 依旧是大多企业的选择。CNCF 最近的一份报告显示,Kubernetes 在全球已拥有近 600 万个企业用户,成为云上应用程序主要的部署模式。

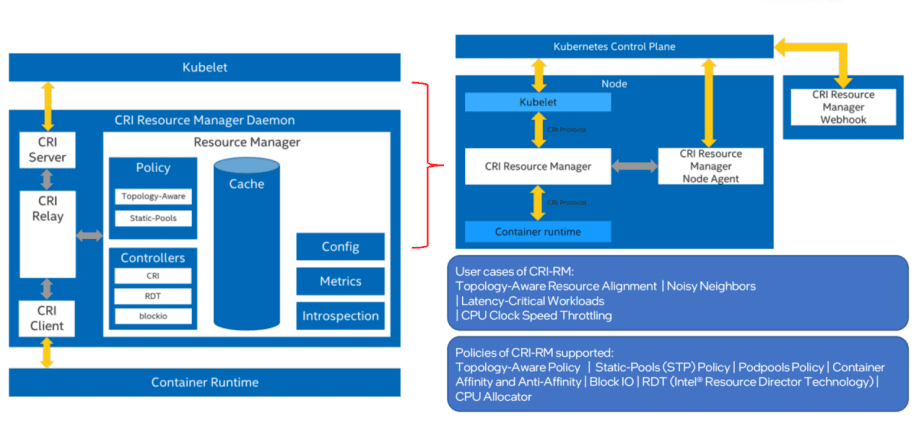

尽管 Kubernetes 覆盖率高,但这也并不意味着已经在应用它的用户满意,常被吐槽“难用但还很需要”。在 Kubernetes 的实际使用过程中,经常会遇见一些“难用”问题,比如创建容器时间过长、低吞吐量 / RPS / 突发并发、容器扩展速度慢、集群扩展速度慢、Sidecar 资源开销、资源利用率低等,为此,英特尔提出了创新的“SW+HW 功能解析”解决方案,开发工作主要集中在资源编排(Orchestration)和可观测行(Observability)两方面:

基于快照 + 热代码块来创建容器;

分片式多调度器;

弹性 POD 的自动扩展;

基于遥测的快速预测,用于实时扩展的决策;

动态插入 / 删除 POD 中的 Sidecar 容器;

链接设备的亲和调度 / 分配 (NUMA, GPU+Smart NIC 等);

实时“节点资源变化”反馈给 Kubernetes 调度器。

以上提到的这些技术都符合 Kubernetes 的 API 规范并可与现有的 API 兼容,确保用户在不修改已有 Kubernetes 代码的情况下便能安装使用。为了方便用户测试、评估这些技术,英特尔还直接提供了容器镜像的方式让用户可以通过 Operator 等标准的 Kubernetes 应用部署方法来安装部署。

解决完容器“难用”问题,就要接着考虑如何“用得好”的问题。“用的好”的前提是选对架构。在后 OpenStack 时代,企业使用云原生架构的目的是追求敏捷、弹性、高性能和效率。要想达到这些目的,单纯依靠软件层面的优化是不够的,以 Serverless 为例,很多部署中会出现的问题,比如函数冷启动等,都需要通过硬件层面的优化来解决。

随着数据逐渐扩散至边缘场景,越来越多的企业期望通过云原生架构实现云边端一体化协同的基础设施,英特尔一直在为此做出努力,聚焦企业发展不同阶段的不同需求,针对性提出架构优化方案。